En intelligence artificielle, plus précisément en apprentissage automatique, le gradient boosting (parfois traduit amplification de gradient en français) est une technique d'apprentissage basée sur le principe de boosting.

Elle consiste à combiner progressivement des modèles faibles, le plus souvent des arbres de décision, pour former un modèle prédictif performant en corrigeant les erreurs résiduelles de manière itérative. Cette méthode repose sur une optimisation séquentielle où chaque nouveau modèle ajuste ses paramètres en minimisant une fonction de coût via le calcul des gradients. Popularisée par des algorithmes comme XGBoost ou LightGBM (en), le gradient boosting s'impose dans des domaines variés, allant de la recommandation à la classification, grâce à son efficacité et sa capacité à traiter des données structurées complexes.

Historique

Le concept de gradient boosting trouve son origine dans une observation de Leo Breiman datant de 1997, selon laquelle le boosting peut être interprété comme un algorithme d'optimisation appliqué à une fonction objectif appropriée. Des algorithmes explicites de gradient boosting dans un contexte de régression statistique ont ensuite été formalisés par Jerome H. Friedman (en) (en 1999, puis en 2001), parallèlement à des approches plus générales proposées par Llew Mason, Jonathan Baxter, Peter Bartlett et Marcus Frean en 1999,. Ces contributions ont introduit une nouvelle interprétation des algorithmes de boosting en tant que méthodes de descente de gradient fonctionnel itératif, c'est-à-dire des procédés optimisant une fonction de coût dans un espace fonctionnel en sélectionnant itérativement une fonction (un « classifieur faible ») orientée dans la direction opposée au gradient. Cette perspective fonctionnelle du gradient a ouvert la voie au développement d'algorithmes de boosting dans divers domaines de l'apprentissage automatique et des statistiques, au-delà de la régression et de la classification.

Principe

Cette section suit le tutoriel A Gentle Introduction to Gradient Boosting par Cheng Li (Northeastern University).

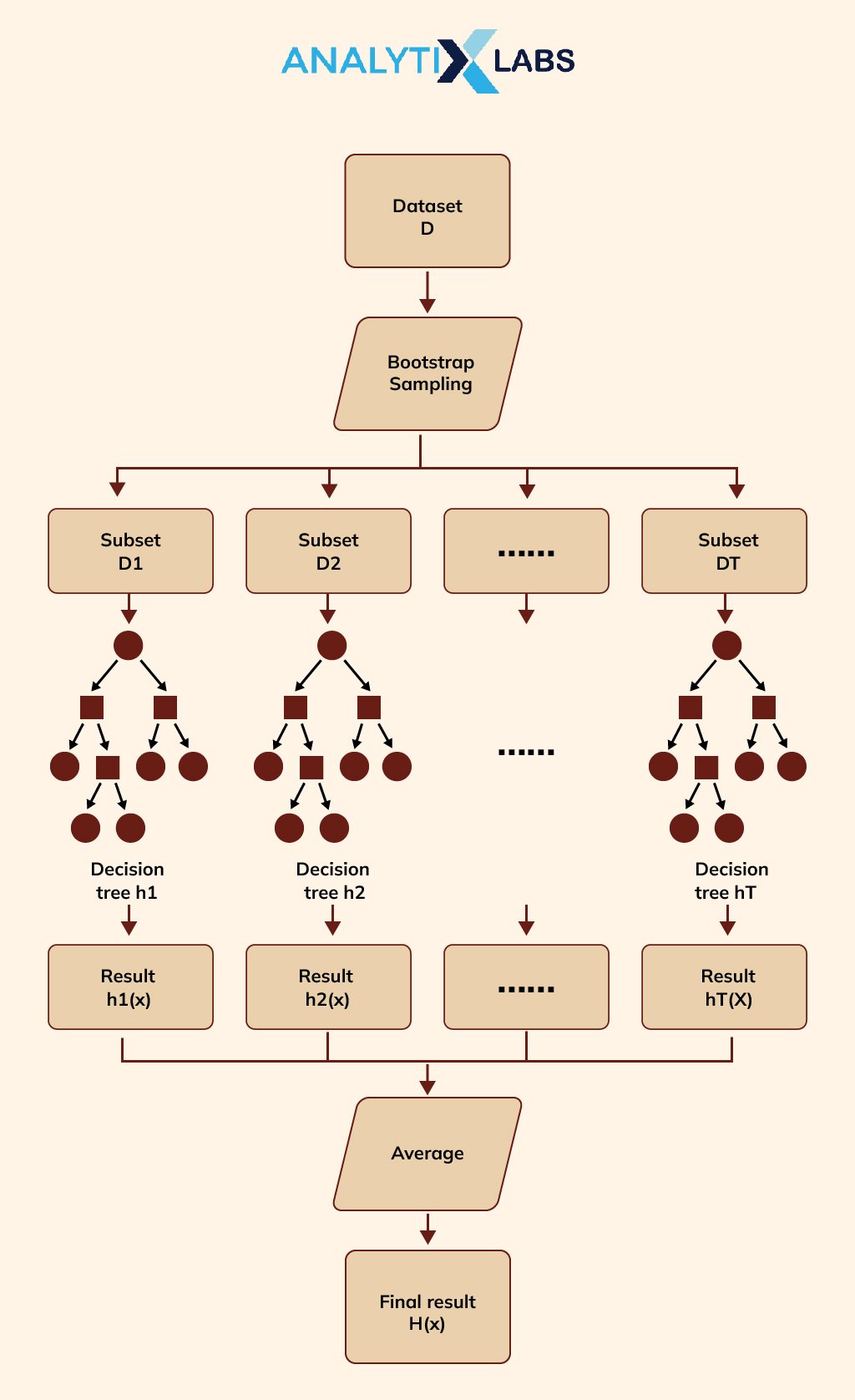

À l'instar des autres méthodes de boosting, le gradient boosting combine des modèles dits faibles en un unique modèle fort par itération. On l'explique ici dans un contexte de régression des moindres carrés. L'objectif est d'apprendre au modèle à prédire des valeurs sous la forme , tout en minimisant l'erreur quadratique moyenne , où est une variable itérée sur un jeu d'entraînement de taille , composé de valeurs de la variable de sortie :

- la valeur prédite

- la valeur observée

- le nombre d'échantillons dans

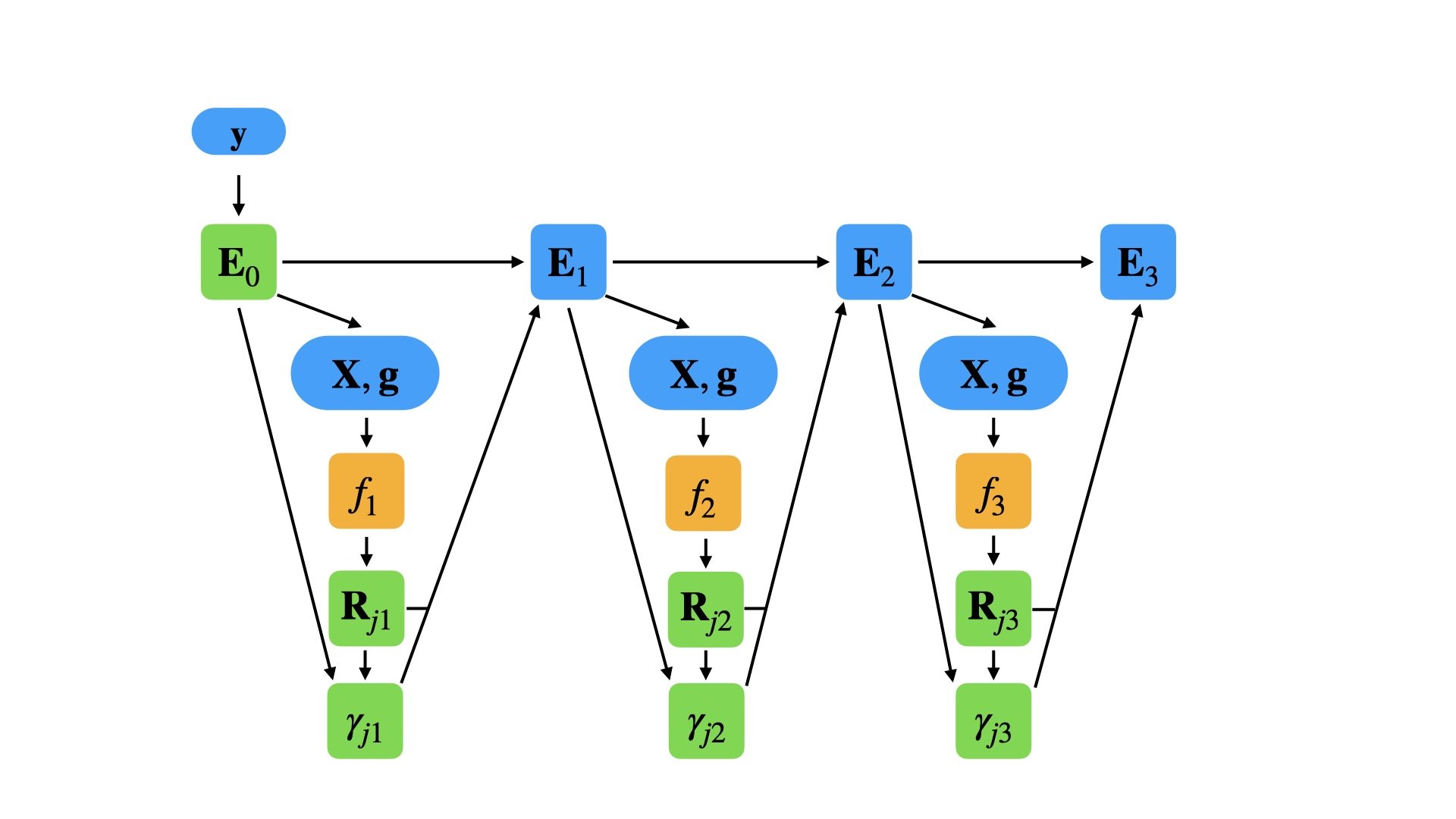

Si l'algorithme comporte étapes, à chaque étape (), supposons un modèle imparfait (pour de faibles , ce modèle peut simplement prédire comme étant , la moyenne de ). Pour améliorer , notre algorithme doit ajouter un nouvel estimateur .

Ainsi,

où, de manière équivalente,

- .

Par conséquent, le gradient boosting ajustera au résidu . Comme dans les autres variantes du boosting, chaque tente de corriger les erreurs de son prédécesseur . Une généralisation de cette idée à des fonctions de perte autres que l'erreur quadratique, ainsi qu'à des problèmes de classification ou de classement, découle de l'observation que les résidus pour un modèle donné sont proportionnels aux gradients négatifs de la fonction de perte d'erreur quadratique moyenne (par rapport à )

- .

Ainsi, le gradient boosting peut être généralisé à un algorithme de descente de gradient en utilisant une fonction de perte différente et son gradient correspondant.

Usages

Le gradient boosting trouve des applications dans le domaine de l'apprentissage par classement. Les moteurs de recherche Yahoo et Yandex emploient des variantes de cette méthode au sein de leurs algorithmes de classement fonctionnant sur de l'apprentissage automatique. Il est également utilisé en physique des particules pour de l'analyse de données, comme celles du Grand collisionneur de hadrons où des variantes de réseaux de neurones profonds s'appuyant sur le gradient boosting appliquées aux jeux de données ont reproduit avec succès les résultats de méthodes d'analyse traditionnelles, non basées sur l'apprentissage automatique, et ont mené à la découverte du boson de Higgs. Par ailleurs, des arbres de décision utilisant le gradient boosting ont été utilisés en géologie, notamment pour évaluer la qualité des réservoirs gréseux ou pour estimer la profondeur des eaux.

Notes et références

Voir aussi

Bibliographie

- (en) Bradley Boehmke et Brandon Greenwell, « Gradient Boosting », dans Hands-On Machine Learning with R, Chapman & Hall, , 484 p. (ISBN 978-1-138-49568-5, lire en ligne), p. 221-245

Articles connexes

- AdaBoost

- Forêt d'arbres décisionnels

- XGBoost

- Portail de l’informatique

- Portail des probabilités et de la statistique

- Portail de l’intelligence artificielle